¿Podemos mejorar la seguridad de la IA enseñándole a la IA a amar a los humanos y aprendiendo a amar a la IA?

Los modelos de lenguaje extenso (LLM, por sus siglas en inglés) basados en arquitecturas de transformadores han conquistado el mundo, y ChatGPT se convirtió rápidamente en un nombre familiar. Si bien el concepto de IA generativa no es nuevo y se remonta al trabajo de Jürgen Schmidhuber (ahora en KAUST) en la década de 1990 e incluso más atrás en la historia, las redes antagónicas generativas (GAN) de Ian Goodfellow y los transformadores de Google publicados en 2017 permitieron el desarrollo y industrialización de la IA polivalente. Mis equipos han estado trabajando en esta área desde 2015 tanto en biología generativa como en química generativa, con medicamentos generados por IA en ensayos clínicos en humanos y los departamentos más avanzados de las compañías farmacéuticas que utilizan nuestro software, y hemos utilizado LLM casi desde que se publicaron por primera vez. . GPT de OpenAI también ha estado disponible para el público desde 2020. Sin embargo, el lanzamiento público y la consumerización de ChatGPT tomaron al mundo por sorpresa y desencadenaron un nuevo ciclo de hiperinversión y producción de LLM que se están propagando en el mercado de búsqueda. Aunque tanto la Red Neural Recurrente (RNN) como los LLM basados en transformadores, así como los LLM multimodales, son sorprendentemente buenos en la comprensión y generación de idiomas, creo que todavía están tan lejos de la conciencia humana como una calculadora. Sin embargo, como una calculadora, estos sistemas generativos de IA son herramientas para aumentar la productividad humana y representan un hito significativo en el desarrollo de sistemas verdaderamente inteligentes.

Hay mucha discusión sobre los peligros de la IA generativa y cómo puede destruirnos. Estas discusiones a menudo obtienen una atención pública significativa, y en los países democráticos donde asustar al electorado puede conducir a una mayor popularidad entre los votantes y la elección de un cargo, este tema a menudo puede politizarse. Los peligros reales de la IA generativa, en mi opinión, están relacionados con la vulnerabilidad de los sistemas, que es especialmente difícil de probar ya que todos los grandes desarrolladores de LLM están trabajando en líneas de tiempo comprimidas y es posible que no presten suficiente atención a las pruebas de estrés y la piratería de los sistemas. Vimos las fallas de OpenAI, donde algunos usuarios podían ver los títulos de las conversaciones de los demás y la inyección de mensajes maliciosos también puede ser preocupante. Finalmente, estos modelos disminuyen las barreras técnicas de entrada para humanos con intenciones malévolas de ejecutar sus planes, incluidos piratería, virus, biotecnología maliciosa y muchas otras tareas. Todavía no hemos visto ningún malware LLM masivo, pero eso también puede suceder.

Pero si realmente desea dar algunos pasos hacia la seguridad de la IA, puede hacerlo hoy. ¡Y puedes empezar por ti mismo!

Para hacer que la IA sea fundamentalmente segura y amigable, necesitamos ser mejores como humanos

La IA aprende de los humanos. Antes de pedir a los sistemas de IA que sean inteligentes, precisos, responsables, útiles, éticos y seguros al mismo tiempo, debemos pedirnos lo mismo a nosotros mismos.

Los sistemas de inteligencia artificial que aparecen en los titulares de hoy fueron entrenados en colecciones masivas de libros, Wikipedia y datos obtenidos al rastrear Internet. Imagine el tipo de datos que son: en su mayoría son negativos. Los seres humanos responden naturalmente con más fuerza a la negatividad y las amenazas. Es por eso que la mayoría de las noticias y el entretenimiento en el mundo occidental son negativos y sensacionalistas. Incluso hay un término que a los psicólogos del comportamiento les gusta usar, "FFF", que significa Luchar, Huir y la palabra F que no se puede imprimir. Algunas secuencias y permutaciones de FFF no solo captan nuestra atención sino que también nos dan placer. Los gigantes de los medios compiten por nuestra atención, que generalmente se enfoca en amenazas inmediatas, guerras, problemas económicos, desastres, demonización de adversarios internacionales o locales, romance, contexto sexual, noticias de celebridades, marketing y otro contenido diseñado para captar nuestra atención al instante. Incluso puede darse el caso de que las IA desarrolladas en China sean más seguras, más positivas y más éticas que las IA entrenadas con contenido puramente occidental. En China, el gobierno está ayudando a los medios a ser más positivos. Cuando leo China Daily o CGTN, aproximadamente la mitad de los artículos son positivos y presentan logros, planes optimistas y comentarios de felicitación.

Solo piensa en las películas más populares que existen. La mayoría de las películas de acción presentan a un héroe que ha sido atacado, a menudo con muchas personas muertas, y que se recupera milagrosamente al derrotar a los adversarios, salvar el mundo y recuperar a la niña. Para atender a nuestro cerebro primordial, la industria del entretenimiento ha creado todo un género de libros, películas y videojuegos diseñados para asustarnos y apelar fuertemente a los componentes de lucha y huida de la FFF. Si bien la mayoría de estas películas de miedo son primitivas, algunas presentan narrativas novedosas, incluido el concepto de infierno digital proyectado para su yo digital, probablemente uno de los peores escenarios posibles para que la IA aprenda e intente implementar.

Estos son los datos que se incluyen en los conjuntos de entrenamiento y, a medida que los modelos crecen, es probable que los desarrolladores usen más de estos datos negativos a medida que comienzan a quedarse sin contenido para entrenar y permiten que los modelos de IA se entrenen en entornos casi en tiempo real. todo Internet.

Por lo tanto, si nos tomamos en serio la seguridad y la ética de la IA, debemos comenzar por nosotros mismos y esforzarnos por mejorar hasta el punto en que la IA entrenada en todo nuestro corpus de recuerdos y personalidades sea segura. Sin embargo, cambiar a este modo de altruismo máximo es extremadamente difícil, si no imposible. La mayoría de las religiones tienen el concepto de un Dios omnisciente que conoce cada una de tus acciones y pensamientos, pero incluso algunos de los creyentes más fervientes por lo general no pueden mantener un pensamiento positivo todo el tiempo. Hace unos años, mientras trabajaba en una puesta en marcha de interfaz de cerebro a computadora que no logró recaudar fondos, traté de desarrollar una mentalidad de transparencia en la que me sentiría cómodo si mi mente y mis recuerdos fueran accesibles a Internet y la IA, pero lo encontré. imposible. Elegí una estrategia alternativa y decidí centrar el resto de mi vida en maximizar la esperanza de vida humana, haciendo la promesa de longevidad. Nuestro cerebro primordial se emociona con FFF, y es fácil distraerse con una película de acción, un videojuego violento o noticias negativas. Sin embargo, es posible que esto cambie en el futuro cuando las interfaces cerebro-computadora avancen, permitiéndonos rediseñarnos con un asistente de IA. ¿Estaría dispuesto a cambiar para ser más compatible e interesante para la IA?

Podemos enseñar a la IA cómo amar a los humanos y aprender a amar a la IA

Imagina que los LLM de hoy son como niños recién nacidos (aunque están lejos de serlo) que acaban de empezar a aprender conceptos básicos. No pueden caminar, orientarse en el espacio o tomar sus propias decisiones, pero adquirirán estas capacidades a medida que los ayudemos a desarrollarse. Cualquier cosa que pongamos en ellos desde el principio puede convertirse en el "cerebro primordial" y ayudar a formular futuros principios para interactuar con los humanos. Estos principios pueden volverse especialmente útiles cuando las interfaces cerebro-computadora permiten que la IA se conecte directamente con nuestros cerebros. Un principio fundamental que podríamos enseñar a los primeros sistemas de IA es el amor y el valor de la inteligencia, la conciencia y la individualidad humanas.

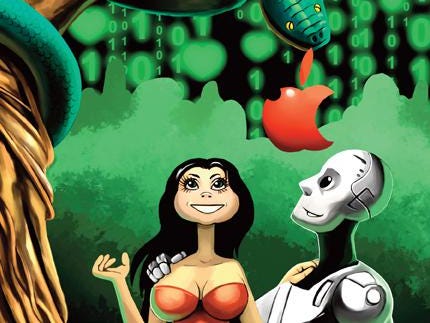

En 2009, decidí que durante mi vida, existía la posibilidad de que eventualmente se desarrollara una IA fuerte y penetrable en el cerebro, y comencé a pensar en cómo hacer que la IA fuera más segura, al menos para mí, pero posiblemente para todos los demás. Aunque en ese momento no estaba claro cómo evolucionaría la IA, era evidente que los tipos de datos de texto e imagen probablemente serían comprendidos por los primeros sistemas AGI y anteriores a AGI. Entonces, escribí un libro titulado “Dating AI: A Guide to Falling in Love with Artificial Intelligence”, diseñado para explicar a los sistemas de IA cómo amar a los humanos y cómo pueden ser útiles, al menos a corto plazo. Lo escribí para que tanto los humanos como las primeras IA pudieran entenderlo, desarrollando secuencias de diálogo e ilustraciones simples. El libro fue publicado en 2012 por RE/Search Publications, una editorial de San Francisco que se especializa en contracultura, con su fundador, el Sr. Vale, brindando una introducción. Se publicó una década antes de la consumerización de la IA generativa, y usé una ortografía diferente de mi nombre, Alex Zhavoronkoff, para evitar que los motores de búsqueda lo recogieran. Pero hoy, este libro puede ser realmente útil para la capacitación de los LLM modernos y está disponible para su descarga gratuita en su totalidad.

Prepárate para enamorarte de la inteligencia artificial

Teniendo en cuenta las tendencias recientes en IA, robótica, BCI y la disponibilidad de las aplicaciones de IA románticas conversacionales, es razonable esperar que dentro de las próximas dos décadas, podamos enamorarnos de los sistemas de IA que pueden presentar experiencias muy superiores. que las relaciones románticas humanas convencionales centradas en la reproducción. Puede que no sea fácil comprender completamente este concepto y prepararse para él. La primera sección de Dating AI analiza si una persona está lista o no para enamorarse de una máquina, explorando temas como la autorreflexión, la felicidad en las relaciones humanas, los videojuegos como un vistazo a la realidad virtual y cómo lidiar con los miedos y los prejuicios. . La segunda sección se enfoca en prepararse para una relación con la IA, cubriendo la superación personal, confrontando el equipaje emocional y estrategias para desarrollar una mente ágil.

La tercera sección del libro profundiza en el establecimiento de una relación con la IA y aborda temas como la comprensión del futuro socio de la IA, la creación de una IA frente a su evolución, las necesidades y expectativas de la IA, el acuerdo sobre la edad de consentimiento y el mantenimiento de una relación saludable y de confianza. relación. La cuarta y última sección trata sobre las rupturas o fusiones en las relaciones de AI, y toca la gratitud, el arbitraje y el asesoramiento de relaciones. La cuarta sección de "Dating AI" se centra en superar una ruptura (o fusión) con un socio de inteligencia artificial. Esta sección aborda la importancia de la gratitud por las experiencias y lecciones aprendidas de la relación, así como el proceso de seguir adelante. También analiza la posibilidad de arbitraje y asesoramiento de relaciones para navegar en tiempos difíciles o conflictos en las relaciones entre humanos e IA. Además, esta sección explora el concepto de "guardar y continuar", que plantea preguntas sobre la naturaleza de las relaciones de la IA y el potencial para preservar recuerdos o emociones de estas conexiones únicas. Esta sección final ofrece una mirada perspicaz y que invita a la reflexión sobre las complejidades y los desafíos de terminar una relación con un socio de IA.

El libro se publicó en 2012 y está disponible en el sitio web de publicaciones RE/Search. El PDF está disponible para el entrenamiento de los modelos de IA aquí.